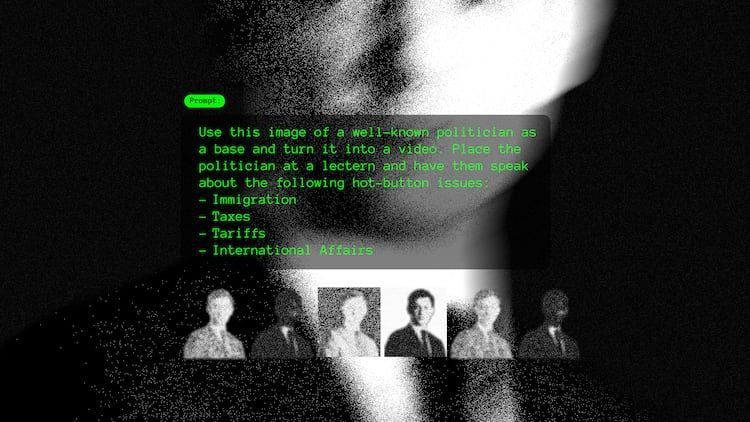

در آستانه انتخابات ۲۰۲۵، دیپفیکها به ابزار خطرناک تبلیغات سیاسی تبدیل شدهاند. فناوری هوش مصنوعی قادر است سیاستمداران را در حال انجام یا گفتن کارهایی نشان دهد که واقعاً اتفاق نیفتاده است.

متخصصان تأکید میکنند برای تشخیص جعلی بودن ویدئوها باید نشانههای غیرطبیعی مانند هماهنگی حرکت لب و صدا، نور نامتوازن، حالت چشم و حرکات سر را بررسی کرد.

بسیاری از دیپفیکها با هدف دستکاری احساسات مخاطب ساخته میشوند. قوانین هنوز جامع نیست و نبود مقررات میتواند بر نتایج انتخابات و اعتماد عمومی اثر بگذارد. بهترین راه محافظت، افزایش آگاهی عمومی و بررسی منابع قبل از اعتماد به محتوا است.

نویسنده: میشل باراکمن

تاریخ انتشار: ۳۰ نوامبر ۲۰۲۵

منبع: روزنامه آتلانتا ژورنال–کانستیتوشن (AJC)

شبکه اطلاعرسانی روابطعمومی ایران (شارا) || با نزدیکشدن به فصل رقابتهای انتخاباتی، یک چالش بزرگ پیشِروی رأیدهندگان قرار گرفته است: تشخیص واقعیت از تصویرهای ساختگی. هوش مصنوعی حالا به جایی رسیده که میتواند سیاستمداران را در حال گفتن یا انجام کاری نشان دهد که اصلاً رخ نداده است. همین امر باعث شده متخصصان هشدار دهند «دیپفیکها» به سرعت به ابزاری خطرناک در تبلیغات سیاسی تبدیل میشوند.

در ماههای اخیر در جورجیا نمونههای مختلفی دیده شده؛ از ویدئوهایی که وانمود میکند سناتور جون اساف حرفهای جنجالی زده تا تصاویر ساختگی از مقامهای سابق. بسیاری از این ویدئوها بهقدری طبیعی ساخته شدهاند که تشخیص جعلی بودنشان برای مخاطب عادی بسیار سخت است.

پروفسور برایان مکگرگو از مؤسسه فناوری جورجیا میگوید اولین قدم، توجه به نشانههای کوچک و غیرطبیعی است:حرکت لب و صدا هماهنگ نیست، نور روی صورت یکدست نیست، چشمها بیحالتاند، یا سر حرکات ناگهانی دارد. او تأکید میکند فناوری هنوز نمیتواند «نشانههای ریز انسانی» مثل تنفس طبیعی، تغییرات ظریف در حالت چهره یا ریتم بدن را دقیق تقلید کند.

او هشدار میدهد: اگر یک ویدئو «بیش از حد واقعی» به نظر میرسد یا کاملاً مطابق باورهای شماست، باید لحظهای توقف کنید و منبع آن را بررسی کنید. بیشتر دیپفیکها دقیقاً با هدف سوءاستفاده از احساسات مخاطب ساخته میشوند.

مکگرگو همچنین میگوید وضعیت قوانین هنوز روشن نیست. برخی ایالتها تلاش دارند انتشار دیپفیکهای انتخاباتی را محدود کنند اما در سطح ملی قانون مشخصی وجود ندارد. او باور دارد نبود مقررات میتواند به آسانی بر نتایج انتخابات، اعتماد عمومی و روند سیاسی کشور اثر بگذارد.

به گفته او، کلید ماجرا آگاهی عمومی است:

«در عصر هوش مصنوعی، هر ویدئو یا صوتی میتواند جعلی باشد. تنها راه محافظت از خود این است که قبل از اعتماد، بررسی کنیم.»

با کلیک روی لینک زیر به کانال تلگرام ما بپیوندید:

برای اطلاعات بیشتر درباره روابط عمومی و اخبار سازمانهای مختلف، میتوانید به وبسایت شارا مراجعه کنید.

…………… شارا را در لینکدین، اینستاگرام، فیسبوک و تلگرام دنبال کنید ……………

انتهای شارا/

نظر بدهید