شبكه اطلاع رساني روابط عمومي ايران (شارا)-|| هوش مصنوعي قرار است زندگي را براي همهي ما آسانتر كند، اين پديده اما مستعد افزايش سوگيريهاي جنسيتزده و نژادپرستانه نيز است.

زندگي مدرن بر پايهي الگوريتمهاي هوشمند جريان دارد. برنامههاي كامپيوتري خودارتقادهنده كه دادهها را ميبلعند و بستر انقلاب هوش مصنوعي هستند همين حالا هم نتايج جستجوي گوگل، فيد خبري فيسبوك و پيشنهادهاي خريد آنلاين را تعيين ميكنند.

حتي بيشتر از اين، تصميم ميگيرند با چه سهولتي وام و يا يك مصاحبهي كاري بگيريم، احتمال توقيف ماشين و گشته شدن توسط پليس در راه خانه، و همچنين اينكه اگر مرتكب جرمي شويم با چه مجازاتهايي روبرو خواهيم شد.

پس بر اين اساس بايد در تصميمگيريهايشان بري از خطا باشند، درست است؟ خير، اشتباه است. دادههاي ورودي منحرفشده، منطق اشتباه يا تنها پيشداوريهاي برنامهنويسان آنها به اين معني هستند كه هوشهاي مصنوعي هم بهراحتي سوگيريهاي انساني را بازتوليد و حتي تشديد ميكنند. پنج مثالي كه در ادامه ميآيند مويد همين نكته هستند.

۱. تبعيض نژادي در الگوريتم كامپِس

كامپس[۱] الگوريتميست كه با پيشبيني احتمال ارتكاب مجدد جرم براي هدايت روند صدور حكم بهطور گسترده در آمريكا استفاده ميشود. احتمالا در بدآوازهترين نمونهي پيشداوري هوش مصنوعي، در ماه مه سال ۲۰۱۶ سازمان خبري غيرانتفاعي پروپوبليكا[۲] گزارش داد كه كامپس از نظر نژادي جانبدارانه است. طبق تحليل پروپوبليكا، سيستم ريسك ارتكاب مجدد جرم توسط متهمان سياهپوست را بيشتر در نظر گرفته و عكس اين حالت را براي متهمان سفيدپوست متصور ميشود. اِكويونت[۳]، شركت توسعهدهندهي نرمافزار، اين مسئله را نميپذيرد.

تشخيص واقعيت، يا اينكه جهتگيري از كجا ممكن است نشات بگيرد، دشوار است، چرا كه الگوريتم در مالكيت انحصاري توسعهدهندگانش بوده و براي بررسي دقيق در دسترس نيست.

اما در هر صورت، اگر مطالعهاي كه در ژانويهي سال ۲۰۱۸ در همين وبسايت منتشر شد را در نظر بگيريم، وقتي نوبت به پيشبيني دقيق اينكه احتمال ارتكاب مجدد جرم از جانب چه كسي بيشتر است ميرسد، اين الگوريتم بهتر از آدمهاي آموزشنديدهاي كه بهصورت تصادفي انتخاب شدهاند عمل نميكند.

۲. پيشداوريهاي الگوريتم پرِدپال

پرِدپال[۴] كه در چندين ايالت آمريكا از آن استفاده ميشود، الگوريتميست كه با هدف كمك به كاهش سوگيريهاي انساني در حفظ نظم، براي پيشبيني زمان و مكان وقوع جرم طراحي شده است. اما در سال ۲۰۱۶، گروه تحليل دادههاي حقوق بشري[۵] به اين پي برد كه نرمافزار ميتواند پليس را به اين سمت هدايت كند كه بعضي از محلهها را به شكلي ناعادلانه هدف بگيرد.

هنگامي كه محققين شبيهسازياي از الگوريتم پرِدپال را در مورد جرائم مربوط به مواد مخدر در اوكلند كاليفرنيا ترتيب دادند، الگوريتم شبيهسازيشده مرتباً افسران پليس را به سمت محلههايي ميفرستاد كه در آنها تعداد زيادي از اقليتهاي نژادي بودند، بدون توجه به ميزان حقيقي جرم و جنايت در آن نواحي.

مديرعامل پرِدپال در پاسخ اشاره ميكند كه دادههاي جرائم مواد مخدر از رسيدن به آستانهي بيطرفي بازمانده و بنابراين در دنياي واقعي بهمنظور اجتناب از پيشداوري، از اين نرمافزار براي پيشبيني جرائم مربوط به مواد مخدر استفاده نميشود. با اينحال سورِش وِنكاتاسوبرامانيان[۶] استاد دانشگاه يوتا و همكارانش ثابت كردند از آنجايي كه نرمافزار بيشتر از گزارشهاي ضبطشده توسط پليس ياد ميگيرد تا از نرخ جرم واقعي، پرِدپال يك «حلقهي بازخورد» ميسازد كه ميتواند سوگيريهاي نژادي را تشديد كند.

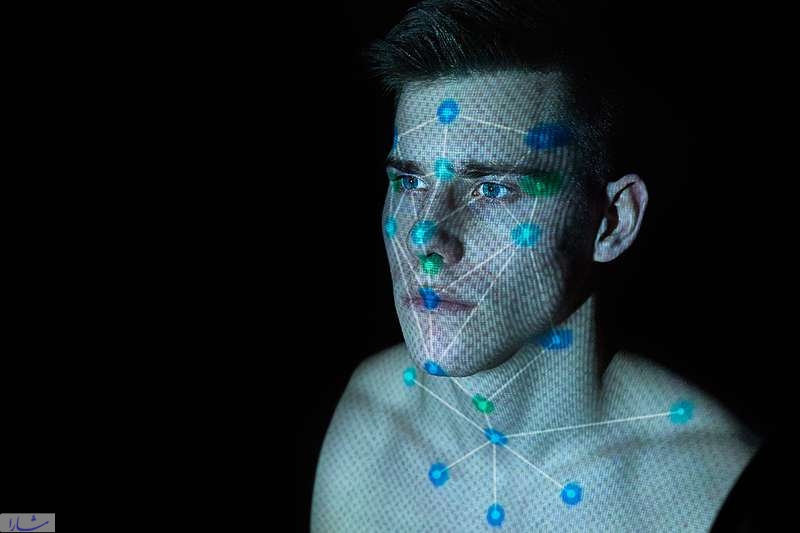

۳. تبعيض نژادي – جنسيتي در نرمافزارهاي تشخيص چهره

نرمافزار تشخيص چهره كه روز به روز بيشتر در نهادهاي مجري قانون استفاده ميشود نيز خاستگاه بالقوهي ديگريست براي سوگيريهاي نژادي و جنسيتي. جوي باولامويني[۷] در دانشگاه اِمآيتي به اين مسئله پي برد كه سه تا از جديدترين هوشهاي مصنوعي تشخيص جنسيت، متعلق به آيبياِم، مايكروسافت و شركت چيني مگوي[۸]، ميتوانستند در ۹۹ درصد موارد جنسيت يك نفر را از روي عكس تشخيص بدهند – اما فقط براي مردان سفيدپوست.

در مورد زنانِ با پوست تيره، دقت به تنها ۳۵ درصد كاهش مييافت. چيزي كه خطر تشخيص اشتباه زنان و اقليتها را افزايش ميدهد. اين مورد نيز احتمالاً به دادههايي كه الگوريتمها بر اساس آنها پرورانده شدهاند برميگردد: اگر به هر نحوي مردان سفيدپوست را بيشتر از زنان سياهپوست دربرميگيرد، در تشخيص مردان سفيدپوست موفقتر است.

آيبياِم بلافاصله اعلام كرد كه سيستمش را با مجموعهاي جديد از دادهها دوباره تعليم داده و مايكروسافت گفت قدمهايي در جهت بهبود دقت برداشته است.

۴. تبعيض جنسيتي در تبليغات گوگل

يك مطالعه در سال ۲۰۱۵ نشان داد كه در قسمت جستجوي تصاوير گوگل براي واژهي «مديرعامل»، تنها ۱۱ درصد از كساني كه نشان داده ميشدند زن بودند، با اينكه ۲۷ درصد از مديران عامل در آمريكا زن هستند. چند ماه بعد، آنوپام داتا[۹] از دانشگاه كارنگي ملونِ پتسبورگ طي تحقيقي به اين موضوع پي برد كه سيستم آنلاين تبليغات گوگل، مشاغل با درآمد بالا را خيلي بيشتر به مردان نشان ميداد تا به زنان.

گوگل به اين نكته اشاره كرد كه متصديان تبليغات ميتوانند مشخص كنند تبليغاتشان فقط به بعضي از كاربرها و يا در بعضي از وبسايتها نشان داده شوند.

شركت به مشتريانش اجازه ميدهد كه آگهيهايشان را بر اساس جنسيت هدفگيري كنند. اما داتا و همكارانش اين ايده را نيز به ذهن متبادر ميكنند كه الگوريتم گوگل ميتوانسته تعيين كند كه مردان به خودي خود براي مناصب اجرايي مناسبتر هستند، اين چيزي است كه از رفتار كاربرانش آموخته: اگر تنها كساني كه آگهيهاي مربوط به مشاغل پردرآمد را ميبينند و روي آن كليك ميكنند مردان هستند، الگوريتم خواهد آموخت كه آن آگهيها را فقط به مردان نشان بدهد.

پي نوشت:

[۱] COMPAS

[۲] ProPublica

[۳] Equivant

[۴] PredPol

[۵] Human Rights Data Analysis Group

[۶] Suresh Venkatasubramanian

[۷] Joy Buolamwini

[۸] Megvii

[۹] Anupam Datta

منبع:

https://www.newscientist.com/article/2166207-discriminating-algorithms-5-times-ai-showed-prejudice/

منبع: ميدان